Secciones del sitio

Selección del editor:

- solo una entidad legal puede ser depositaria

- Acumulación y uso de puntos sobre ozono

- ¿Qué puede hacer con los bonos de agradecimiento de Sberbank en la tienda en línea de OZON?

- Operaciones bancarias y sus tipologías

- ¿Qué comisión toma el corredor?

- Información privilegiada bancaria o "Prohibida la entrada no autorizada"

- Transición de la construcción compartida a la financiación de proyectos

- Cobro de efectivo: transacciones

- Cómo comprar acciones de Sberbank para un individuo y recibir dividendos

- Promociones rentables en depósitos de Sberbank para el Año Nuevo, intereses en el "Año Nuevo

Publicidad

| Análisis de varianza de una sola vía. Análisis de varianza multivariado Artículo de análisis de varianza |

|

ANOVA basado en los trabajos del famoso matemático R.A. Fisher... A pesar de la "edad" bastante sólida, este método sigue siendo uno de los principales en la investigación biológica y agrícola. Las ideas que subyacen al análisis de varianza se utilizan ampliamente en muchos otros métodos de análisis matemático de datos experimentales, así como en la planificación de experimentos biológicos y agrícolas. El análisis de varianza le permite: 1) comparar dos o más medias muestrales; 2) estudiar simultáneamente la acción de varios factores independientes, mientras es posible determinar tanto el efecto de cada factor en la variabilidad del rasgo estudiado, como su interacción; 3) planificar correctamente un experimento científico. La variabilidad de los organismos vivos se manifiesta en forma de dispersión o dispersión de los valores de los rasgos individuales dentro de los límites que están determinados por el grado de uniformidad biológica del material y la naturaleza de la relación con las condiciones ambientales. Los signos que cambian bajo la influencia de ciertas razones se denominan eficaz. Los factores son cualquier influencia o condición, cuya diversidad puede afectar de alguna manera la diversidad del rasgo efectivo. La influencia estadística de los factores en el análisis de varianza se entiende como el reflejo en la diversidad del indicador efectivo de la diversidad de los factores estudiados, que se organiza en el estudio. Por diversidad nos referimos a la presencia de valores desiguales de cada rasgo en diferentes individuos combinados en un grupo. La diversidad de un grupo de individuos según el rasgo en estudio puede tener un grado diferente, que suele medirse mediante indicadores de diversidad (o variabilidad): límites, desviación estándar, coeficiente de variación. En el análisis de varianza, el grado de diversidad de los valores individuales y promedio de un rasgo se mide y se compara de formas especiales que conforman las características específicas de este método general. La organización de los factores es que se asignan varios valores a cada factor estudiado. De acuerdo con estos valores, cada factor se divide en varias gradaciones; para cada gradación, se seleccionan varios individuos según el principio de muestreo aleatorio, en el que posteriormente se mide el valor del rasgo efectivo. Para conocer el grado y confiabilidad de la influencia de los factores estudiados, es necesario medir y evaluar esa parte de la diversidad total que es causada por estos factores. Los factores que afectan el grado de variación del rasgo efectivo se dividen en: 1) ajustable 2) aleatorio Regulado (sistemático) los factores son causados por la acción del factor estudiado en el experimento, que tiene varias gradaciones en el experimento. Gradación de factores- este es el grado de su impacto en la característica efectiva. De acuerdo con la gradación del atributo, se resaltan varias variantes del experimento para comparar. Dado que estos factores están preacondicionados, se denominan regulados en la investigación, es decir, dado, dependiendo de la organización del experimento. En consecuencia, los factores ajustables son factores cuya acción se estudia en la experiencia, son ellos los que determinan las diferencias entre las medias muestrales de diferentes opciones - varianza intergrupal (factorial). Factores aleatorios están determinadas por la variación natural de todos los signos de los objetos biológicos en la naturaleza. Estos son factores que escapan al control de la experiencia. Tienen un efecto aleatorio sobre el rasgo efectivo, causan errores experimentales y determinan la dispersión (dispersión) del rasgo dentro de cada variante. Esta propagación se llama varianza intragrupal (aleatoria). Por lo tanto, el papel relativo de los factores individuales en la variabilidad general del rasgo efectivo se caracteriza por la varianza y se puede estudiar utilizando análisis de varianza o análisis de dispersión ANOVA se basa en comparación de variaciones entre grupos y dentro del grupo... Si la varianza intergrupal no excede la varianza intragrupo, entonces las diferencias entre los grupos son aleatorias. Si la varianza intergrupal es significativamente mayor que la varianza intragrupo, entonces entre los grupos estudiados (opciones) existen diferencias estadísticamente significativas debido al efecto del factor estudiado en el experimento. De esto se deduce que en el estudio estadístico del rasgo efectivo mediante análisis de varianza, es necesario determinar su variación en variantes, repeticiones, variación residual dentro de estos grupos y la variación general del rasgo efectivo en el experimento. De acuerdo con esto, se distinguen tres tipos de dispersiones: 1) La varianza general del rasgo efectivo (S y 2); 2) Intergrupal, o privado, entre muestras (S y 2); 3) Intragrupo, residual (S z 2). Por eso, Análisis de variación – Esta es la división de la suma total de los cuadrados de las desviaciones y el número total de grados de libertad en partes o componentes correspondientes a la estructura del experimento, y la evaluación de la importancia de la acción e interacción de los factores en estudio. según el criterio F. Dependiendo del número de factores estudiados simultáneamente, se distingue el análisis de varianza de dos, tres o cuatro factores. Cuando se procesan complejos estadísticos de un factor de campo que constan de varias variantes independientes, la variabilidad total del rasgo efectivo, medida por la suma total de cuadrados (C y), se divide en tres componentes: la variación entre las variantes (muestras) - CV , la variación de las repeticiones (las variantes están relacionadas por una condición controlada común - la presencia de repeticiones organizadas) - C p y la variación dentro de las opciones C z. En forma general, la variabilidad de un rasgo está representada por la siguiente expresión: C y = C V + C p + C z. El número total de grados de libertad (N -1) también se divide en tres partes: grados de libertad de opciones (l - 1); grados de libertad para repeticiones (n - 1); variación aleatoria (n - 1) × (l - 1). Las sumas de los cuadrados de las desviaciones, de acuerdo con un experimento de campo, un complejo estadístico con opciones ly repeticiones n, se encuentran de la siguiente manera. Primero, usando la tabla inicial, se determinan las sumas de las repeticiones - Σ P, para las variantes - Σ V y la suma total de todas las observaciones - Σ X. Luego se calculan los siguientes indicadores: El número total de observaciones N = l × n; Factor de corrección (enmienda) C cor = (Σ X 1) 2 / N; La suma total de cuadrados Cy = Σ X 1 2 - C cor; La suma de cuadrados para las repeticiones C p = Σ P 2 / (l –C cor); La suma de cuadrados para las opciones C V = Σ V 2 / (n - 1); La suma de los cuadrados del error (resto) C Z = C y - C p - C V. Las sumas resultantes de los cuadrados C V y C Z se dividen por los grados de libertad que les corresponden y se obtienen dos cuadrados medios (varianzas): Variantes S v 2 = C V / l - 1; Errores S Z 2 = C Z / (n - 1) × (l - 1). Evaluación de la importancia de las diferencias entre las medias. Los cuadrados medios obtenidos se utilizan en análisis de varianza para evaluar la significancia de la acción de los factores en estudio comparando la varianza de opciones (S v 2) con la varianza del error (SZ 2) según el criterio de Fisher (F = SY 2 / SZ 2). La unidad de comparación es el cuadrado medio de la varianza aleatoria, que determina el error aleatorio del experimento. El uso de la prueba de Fisher permite establecer la presencia o ausencia de diferencias significativas entre las medias muestrales, pero no indica diferencias específicas entre las medias. La hipótesis H o probada es la suposición de que todas las medias muestrales son estimaciones de un promedio general y las diferencias entre ellas son insignificantes. Si F hecho = S Y 2 / S Z 2 ≤ F teor, entonces la hipótesis nula no se rechaza. No existen diferencias significativas entre las medias muestrales, y aquí es donde termina la prueba. La hipótesis nula se rechaza por F hecho = S Y 2 / S Z 2 ≥ F teor El valor del criterio F para el nivel de significancia adoptado en el estudio se encuentra en la tabla correspondiente, teniendo en cuenta los grados de libertad para la varianza de variantes y varianza aleatoria. Por lo general, utilizan un nivel de significancia del 5% y, con un enfoque más riguroso, del 1% e incluso del 0,1%. Para una muestra de tamaño n, la varianza muestral se calcula como la suma de las desviaciones cuadradas de la media muestral, dividida por n-1(tamaño de la muestra menos uno). Por lo tanto, para un tamaño de muestra fijo n, la varianza es una función de la suma de cuadrados (desviaciones), denotada, por brevedad, SS (del inglés Sum of Squares - Suma de cuadrados). Además, a menudo omitimos la palabra muestra, sabiendo muy bien que se está considerando la varianza de la muestra o la estimación de la varianza. El análisis de varianza se basa en dividir la varianza en partes o componentes.: Errores SS y SS efecto. Variabilidad intragrupo ( SS) generalmente se denomina componente residual o varianza errores. Esto significa que, por lo general, en un experimento no se puede predecir ni explicar. Por otro lado, Efecto SS(o el componente de varianza entre grupos) puede explicarse por la diferencia entre las medias de los grupos. En otras palabras, pertenecer a un determinado grupo explica variabilidad intergrupal, porque sabemos que estos grupos tienen diferentes valores medios. Lógica básica de análisis de varianza. Resumiendo, podemos decir que el propósito del ANOVA es probar la significancia estadística de la diferencia entre las medias (para grupos o variables). Esta verificación se lleva a cabo dividiendo la suma de cuadrados en componentes, es decir dividiendo la varianza total (variación) en partes, una de las cuales se debe a un error aleatorio (es decir, la variabilidad intragrupo) y la segunda se asocia con la diferencia en los valores medios. El último componente de la varianza se utiliza luego para analizar la significación estadística de la diferencia entre las medias. Si esta es la diferencia significativamente, hipótesis nula rechazado y se acepta una hipótesis alternativa sobre la existencia de una diferencia entre las medias. Variables dependientes e independientes. Las variables cuyos valores se determinan mediante mediciones durante el experimento (por ejemplo, la puntuación obtenida durante la prueba) se denominan dependiente variables. Las variables que se pueden controlar en el experimento (por ejemplo, métodos de enseñanza u otros criterios que le permiten dividir las observaciones en grupos o clasificar) se denominan factores o independiente variables. Muchos factores. El mundo es intrínsecamente complejo y multidimensional. Las situaciones en las que un determinado fenómeno se describe completamente mediante una variable son extremadamente raras. Por ejemplo, si estamos tratando de aprender a cultivar tomates grandes, se deben considerar los factores relacionados con la estructura genética de la planta, el tipo de suelo, la luz, la temperatura, etc. Por lo tanto, hay muchos factores con los que lidiar en un experimento típico. La principal razón por la que el uso del análisis de varianza es preferible a la comparación repetida de dos muestras en diferentes niveles de factores utilizando series t- El criterio es que el análisis de varianza es significativamente más eficiente y, para muestras pequeñas, es más informativo. Producción. El análisis de varianza fue desarrollado e introducido en la práctica de la investigación agrícola y biológica por el científico inglés R.A. Fisher. . La esencia del análisis de varianza Consiste en la descomposición de la variabilidad total de la característica y el número total de grados de libertad en partes componentes correspondientes a la estructura del experimento de campo, también en la evaluación del factor de actuación según el criterio de Fisher. Donde se encuentra la variabilidad general del rasgo, debido a la acción de la pregunta en estudio, la heterogeneidad de la fertilidad del suelo y los errores aleatorios en el experimento. Rendimientos variables basados en repeticiones del experimento de campo. Variación de rendimientos por variantes de experiencia asociadas a la acción de la cuestión en estudio. Variaciones en los rendimientos asociadas a errores aleatorios en la experiencia. Producción El análisis de varianza se realiza de acuerdo con las siguientes reglas: 1. Hay diferencias significativas en la experiencia si factual ≥ teórico. No hay diferencias significativas en la experiencia si F es el valor real 2. NDS: la diferencia significativa más pequeña, utilizada para determinar la diferencia entre opciones. Si la diferencia d ≥ NSR, entonces las diferencias entre las opciones son significativas. Si d< НСР, то различия между вариантами не существенные. Grupos opciones. 1. Si la diferencia d es significativa e indica un aumento en el rendimiento, las opciones se refieren al grupo 1. 2. Si la diferencia d– no es significativa, las opciones se refieren al grupo 2. 3. Si la diferencia d es significativa, pero indica una disminución en el rendimiento, las opciones se refieren al grupo 3. Elegir una fórmula ANOVA depende de los métodos de colocación de opciones en el experimento: 1. Para repeticiones organizadas: 2. Para repeticiones desorganizadas. 5.1. ¿Qué es ANOVA? El análisis de varianza fue desarrollado en la década de 1920 por el matemático y genetista inglés Ronald Fisher. Según una encuesta entre científicos, donde se descubrió quién influyó más en la biología del siglo XX, fue Sir Fisher quien ganó el campeonato (por sus servicios recibió el título de caballero, una de las más altas distinciones en Gran Bretaña); a este respecto, Fischer es comparable a Charles Darwin, quien tuvo la mayor influencia en la biología en el siglo XIX. El análisis de varianza es ahora una rama separada de la estadística. Se basa en el hecho descubierto por Fisher de que la medida de variabilidad de la cantidad estudiada puede descomponerse en partes correspondientes a los factores que influyen en esta cantidad y desviaciones aleatorias. Para comprender la esencia del análisis de varianza, realizaremos el mismo tipo de cálculos dos veces: “manualmente” (con una calculadora) y usando el programa Statistica. Para simplificar nuestra tarea, no trabajaremos con los resultados de una descripción real de la diversidad de ranas verdes, sino con un ejemplo ficticio que se relaciona con la comparación de mujeres y hombres en humanos. Considere la diversidad de estatura de 12 adultos: 7 mujeres y 5 hombres. Realicemos un análisis de varianza unidireccional: compararemos si los hombres y las mujeres del grupo descrito difieren en términos de altura estadísticamente significativa o no. El razonamiento adicional se basa en el hecho de que la distribución en la muestra considerada es normal o cercana a la normal. Si la distribución está lejos de ser normal, la varianza (varianza) no es una medida adecuada de su variabilidad. Sin embargo, ANOVA es relativamente robusto a las desviaciones de la distribución de la normalidad. La normalidad de estos datos se puede probar de dos formas diferentes. Primero: Estadísticas / Estadísticas básicas / Tablas / Estadísticas descriptivas / pestaña Normalidad. En la pestaña Normalidad puede elegir las pruebas utilizadas para la normalidad de la distribución. Al hacer clic en el botón Tablas de frecuencias, aparecerá una tabla de frecuencias y los botones Histogramas: un histograma. La tabla y el gráfico de barras mostrarán los resultados de varias pruebas. El segundo método está relacionado con el uso de lo posible apropiado al construir histogramas. En el cuadro de diálogo para crear histogramas (gráficos / histogramas ...), seleccione la pestaña Avanzado. En su parte inferior hay un bloque de Estadísticas. Marquemos a Shapiro-Wilk en él t est y la prueba de Kolmogorov-Smirnov, como se muestra en la figura. Como puede verse en el histograma, la distribución del crecimiento en nuestra muestra difiere de la normal (en el medio - "falla"). La tercera línea en el título del gráfico indica los parámetros de la distribución normal a los que se acercó más la distribución observada. El promedio general es 173, la desviación estándar general es 10,4. A continuación, en la barra lateral del gráfico, se encuentran los resultados de las pruebas de normalidad. D es la prueba de Kolmogorov-Smirnov y SW-W es la prueba de Shapiro-Vilk. Como se puede observar, para todas las pruebas utilizadas, las diferencias entre la distribución de la altura y la distribución normal resultaron ser estadísticamente insignificantes ( pag

en todos los casos más de 0,05). Entonces, formalmente hablando, las pruebas de conformidad de una distribución con una distribución normal no nos "prohibieron" usar un método paramétrico basado en el supuesto de una distribución normal. Como ya se mencionó, el análisis de varianza es relativamente resistente a las desviaciones de la normalidad, por lo que aún lo usaremos. Para caracterizar la variabilidad de la altura de las personas en el ejemplo dado, calculamos la suma de los cuadrados de las desviaciones (en inglés se denota como SS

, Suma de cuadrados o) valores individuales de la media: SS

= (186–173) 2 + (169–173) 2 + (166–173) 2 + (188–173) 2 + (172–173) 2 + (179–173) 2 + (165–173) 2 + (174–173) 2 + (163–173) 2 + (162–173) 2 + (162–173) 2 + (190–173) 2 ; SS

= 132 + 42 + 72 + 152 + 12 + 62 + 82 + 12 + 102 + 112 + 112 + 172;

SS

= 169 + 16 + 49 + 225 + 1 + 36 + 64 + 1 + 100 + 121 + 121 + 289 = 1192.

El valor resultante (1192) es una medida de la variabilidad de todo el conjunto de datos. Sin embargo, constan de dos grupos, para cada uno de los cuales se puede distinguir su propia media. En los datos anteriores, la altura promedio de las mujeres es de 168 cm y de los hombres, de 180 cm. Calculemos la suma de los cuadrados de las desviaciones para las mujeres: SS f

= (169–168) 2 + (166–168) 2 + (172–168) 2 + (179–168) 2 + (163–168) 2 + (162–168) 2 ;

SS f

= 12 + 22 + 42 + 112 + 32 + 52 + 62 = 1 + 4 + 16 + 121 + 9 + 25 + 36 = 212.

También calculamos la suma de los cuadrados de las desviaciones para los hombres: SS m

= (186–180) 2 + (188–180) 2 + (174–180) 2 + (162–180) 2 + (190–180) 2 ;

SS m

= 62 + 82 + 62 + 182 + 102 = 36 + 64 + 36 + 324 + 100 = 560.

¿De qué depende el valor investigado de acuerdo con el análisis de la lógica de varianza? Dos valores calculados, SS f

y SS m

, caracterizan la varianza intragrupo, que en el análisis de varianza se suele denominar "error". El origen de este nombre está asociado con la siguiente lógica. ¿Qué determina el crecimiento de una persona en este ejemplo? En primer lugar, a partir de la altura media de las personas en general, independientemente de su sexo. En segundo lugar, desde el suelo. Si las personas de un sexo (hombre) son más altas que el otro (mujer), esto se puede representar como una adición al promedio de “humanos comunes” de algún tamaño, el efecto del género. Finalmente, las personas del mismo sexo difieren en altura debido a diferencias individuales. En un modelo que describe la altura como la suma del promedio humano y el ajuste de género, las diferencias individuales son inexplicables y pueden considerarse "error". Entonces, de acuerdo con la lógica del análisis de varianza, el valor investigado se determina de la siguiente manera: Suma de cuadrados intergrupal Entonces, SS

errores

= SS f + SS m

= 212 + 560 = 772. Con este valor, describimos la variabilidad intragrupal (cuando los grupos se identificaban por género). Pero también hay una segunda parte de la variabilidad: el intergrupo, al que llamaremosEfecto SS

(ya que estamos hablando del efecto de dividir el conjunto de objetos en consideración en mujeres y hombres). El promedio de cada grupo es diferente del promedio general. Calculando la contribución de esta diferencia a la medida total de variabilidad, debemos multiplicar la diferencia entre el grupo y el promedio total por el número de objetos en cada grupo. Efecto SS

= = 7 × (168-173) 2 + 5 × (180-173) 2 = 7 × 52 + 5 × 72 = 7 × 25 + 5 × 49 = 175 + 245 = 420. Aquí se manifestó el principio de la constancia de la suma de cuadrados, descubierto por Fischer: SS = efecto SS + error SS

, es decir. para este ejemplo, 1192 = 440 + 722. Cuadrados medios Comparando en nuestro ejemplo las sumas de cuadrados intergrupales e intragrupales, podemos ver que el primero está asociado con la variación de dos grupos, y el segundo - 12 valores en 2 grupos. El número de grados de libertad ( df

) para algún parámetro se puede definir como la diferencia entre el número de objetos en el grupo y el número de dependencias (ecuaciones) que conecta estos valores. En nuestro ejemplo efecto df

= 2–1

= 1, a errores df

= 12–2

= 10.

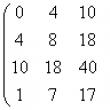

Podemos dividir las sumas de cuadrados por el número de sus grados de libertad, obteniendo los cuadrados medios ( SRA

, Medios de Cuadrados). Habiendo hecho esto, podemos establecer que SRA

- nada más que varianza ("varianza", el resultado de dividir la suma de cuadrados por el número de grados de libertad). Después de este descubrimiento, podemos comprender la estructura de la tabla ANOVA. En nuestro ejemplo, se verá así. el efecto Error Efecto MS

y Errores de MS

son estimaciones de la varianza intergrupal e intragrupo y, por tanto, pueden compararse según el criterioF

(Criterio de Snedecor, llamado así por Fisher), diseñado para comparar varianzas. Este criterio es simplemente el cociente de dividir la varianza mayor por la menor. En nuestro caso, esto es 420 / 77.2 = 5.440. Determinación de la significancia estadística de la prueba de Fisher mediante tablas Si tuviéramos que determinar la significancia estadística del efecto manualmente, usando tablas, necesitaríamos comparar el valor obtenido del criterio F

con crítico, correspondiente a un cierto nivel de significación estadística para grados de libertad dados. Como puede ver, para el nivel de significancia estadística p = 0.05, el valor crítico del criterioF

es 4,96. Esto significa que en nuestro ejemplo, la acción del sexo estudiado se registró con un nivel de significancia estadística de 0.05. El resultado se puede interpretar de la siguiente manera. La probabilidad de la hipótesis nula, según la cual la estatura promedio de mujeres y hombres es la misma, y la diferencia registrada en su estatura se asocia con la aleatoriedad en la formación de las muestras, es menor al 5%. Esto significa que debemos elegir una hipótesis alternativa de que la estatura promedio de mujeres y hombres es diferente. En los casos en que los cálculos no se realizan manualmente, sino con la ayuda de programas apropiados (por ejemplo, el paquete Statistica), el valor pag

se determina automáticamente. Puede asegurarse de que sea ligeramente superior al valor crítico. Para analizar el ejemplo discutido utilizando la variante más simple de análisis de varianza, debe ejecutar el procedimiento Estadísticas / ANOVA para el archivo con los datos correspondientes y seleccionar la opción ANOVA unidireccional en la ventana Tipo de análisis y el cuadro de diálogo Especificaciones rápidas. opción en la ventana Método de especificación ... En la ventana de diálogo rápido abierta, en el campo Variables, debe especificar aquellas columnas que contienen los datos, cuya variabilidad estamos estudiando (Lista de variables dependientes; en nuestro caso, la columna Crecimiento), así como la columna que contiene valores que dividen el valor estudiado en grupos (predictor catigórico (factor); en nuestro caso, la columna Sexo). En esta versión del análisis, a diferencia del análisis multivariado, solo se puede considerar un factor. En la ventana Códigos de factor, debe especificar los valores del factor en consideración que deben procesarse en el curso de este análisis. Todos los valores disponibles se pueden ver usando el botón Zoom; si, como en nuestro ejemplo, necesita considerar todos los valores del factor (y para el género en nuestro ejemplo solo hay dos de ellos), puede hacer clic en el botón Todos. Una vez definidas las columnas a procesar y los códigos de los factores, puede hacer clic en el botón Aceptar e ir al análisis rápido de los resultados: Resultados ANOVA 1, a la pestaña Rápido. El botón Todos los efectos / Gráficos le permite ver cómo se comparan los promedios de los dos grupos. Sobre el gráfico, se indica el número de grados de libertad, así como los valores de F y p para el factor en consideración. El botón Todos los efectos le permite obtener una tabla de ANOVA similar a la descrita anteriormente (con algunas diferencias significativas). La línea inferior de la tabla muestra la suma de cuadrados, el número de grados de libertad y los cuadrados medios del error (variabilidad intragrupo). Una línea arriba: indicadores similares para el factor en estudio (en este caso, el signo del sexo), así como el criterio F

(la relación entre los cuadrados medios del efecto y los cuadrados medios del error) y el nivel de su significación estadística. El hecho de que el efecto del factor en cuestión resultó ser estadísticamente significativo se muestra mediante el resaltado en rojo. La primera línea contiene datos sobre el indicador "Intercepción". Esta la fila de la tabla presenta un misterio para los usuarios nuevos de Statistica en su sexta versión o posterior. El valor de Intercepción probablemente esté relacionado con la descomposición de la suma de cuadrados de todos los valores de datos (es decir, 1862 + 1692 ... = 360340). El valor del criterio F indicado para él se obtiene dividiendo Intercepción de MS / Error de MS

= 353220 / 77.2 = 4575.389 y naturalmente da un valor muy bajo pag

... Curiosamente, en Statistica-5 este valor no se calculó en absoluto, y los manuales para usar versiones posteriores del paquete no comentan su introducción de ninguna manera. Probablemente lo mejor que puede hacer un biólogo que trabaja con Statistica-6 y posteriores es simplemente ignorar la fila de Intercepción en la tabla ANOVA. Como habrás notado, los datos que comparamos mediante el análisis de varianza unidireccional, también podríamos investigar utilizando las pruebas de Student y Fisher. Comparemos estos dos métodos. Para ello, calcule la diferencia de altura entre hombres y mujeres utilizando estos criterios. Para ello, tendremos que recorrer el camino Estadísticas / Estadísticas básicas / t-test, independientes, por grupos. Naturalmente, las variables dependientes es la variable de crecimiento y la variable de agrupación es la variable de sexo. Como puede ver, el resultado es el mismo que con ANOVA. pag

= 0.041874 en ambos casos, como se muestra en la Fig. 5 y se muestra en la Fig. 5.5.2 (¡compruébelo usted mismo!). Es importante resaltar que si bien el criterio F desde el punto de vista matemático en el análisis considerado según los criterios de Student y Fisher es el mismo que en ANOVA (y expresa la razón de varianza), su significado en los resultados del análisis presentados en el La mesa final es completamente diferente. Al comparar según los criterios de Student y Fisher, la comparación de los valores medios de las muestras se realiza según el criterio de Student, y la comparación de su variabilidad se realiza según el criterio de Fisher. En los resultados del análisis, no se muestra la varianza en sí, sino su raíz cuadrada, la desviación estándar. En ANOVA, por el contrario, la prueba de Fisher se utiliza para comparar las medias de diferentes muestras (como comentamos, esto se hace dividiendo la suma de cuadrados en partes y comparando la media de la suma de cuadrados correspondiente a la variabilidad entre y dentro de los grupos) . Sin embargo, la diferencia anterior se refiere a la presentación de los resultados de un estudio estadístico más que a su esencia. Como señaló, por ejemplo, Glantz (1999, p. 99), la comparación de grupos mediante la prueba de Student se puede considerar como un caso especial de análisis de varianza para dos muestras. Por lo tanto, comparar muestras de acuerdo con las pruebas de Student y Fisher tiene una ventaja importante sobre el análisis de varianza: puede comparar muestras en términos de su variabilidad. Pero los beneficios del análisis de varianza son aún más significativos. Estos incluyen, por ejemplo, la capacidad de comparar varias muestras al mismo tiempo. El esquema de análisis de varianza considerado se diferencia en función de: a) la naturaleza de la característica por la cual la población se subdivide en grupos (muestras;); b) la cantidad de características por las que la población se subdivide en grupos (muestras) ; c) sobre el método de muestreo. Valores característicos. que subdivide la población en grupos puede representar la población general o una población cercana a ella. En este caso, el esquema ANOVA corresponde al discutido anteriormente. Si los valores de una característica que forma diferentes grupos representan una muestra de la población general, entonces la formulación de la hipótesis cero y alternativa cambia. Como hipótesis nula, se asume que existen diferencias entre grupos, es decir, las medias de los grupos muestran alguna variación. Como hipótesis alternativa, se sugiere que no hay oscilación. Obviamente, con tal formulación de hipótesis, no hay razón para concretar los resultados de comparar varianzas. Con un aumento en el número de características de agrupación, por ejemplo, hasta 2, en primer lugar, aumenta el número de cero y, en consecuencia, las hipótesis alternativas. En este caso, la primera hipótesis nula habla de la ausencia de diferencias entre las medias para los grupos del primer rasgo de agrupamiento, la segunda hipótesis nula habla de la ausencia de diferencias en las medias para los grupos del segundo rasgo de agrupación, y finalmente la tercera hipótesis nula indica la ausencia del llamado efecto de interacción de factores (características de agrupamiento). El efecto de interacción se entiende como un cambio en el valor de un atributo efectivo que no puede explicarse por la acción total de dos factores. Para probar los tres pares de hipótesis planteados, es necesario calcular tres valores reales del criterio F-Fisher, que a su vez sugiere la siguiente variante de descomposición del volumen total de variación Las dispersiones necesarias para obtener el criterio F se obtienen de manera conocida dividiendo los volúmenes de variación por el número de grados de libertad. Como sabe, las muestras pueden ser dependientes e independientes. Si las muestras son dependientes, entonces, en la cantidad total de variación, se debe distinguir la denominada variación por réplicas. Preguntas de revisión 17-1 ¿Cuál es la especificación de los resultados del análisis de varianza? 17-2. ¿Cuándo se utiliza el criterio Q-Tukey para la concretización? 17-3. ¿Cuáles son las diferencias entre el primer, el segundo y así sucesivamente? 17-4. ¿Cómo encontrar el valor real de la prueba Q de Tukey? 17-5 ¿Qué hipótesis se plantean sobre cada diferencia? 17-6. ¿De qué depende el valor tabular del criterio Q de Tukey? 17-7. ¿Cuál es la hipótesis nula si los niveles del atributo de agrupación son una muestra? 17-8 ¿Cómo se descompone la cantidad total de variación cuando los datos se agrupan de acuerdo con dos criterios? 17-9. En cuyo caso se destaca la variación en las repeticiones ( Resumen El mecanismo considerado de especificar los resultados del análisis de varianza le permite darle una mirada completa. Se debe prestar atención a las limitaciones al utilizar la prueba Q de Tukey. El material también describió los principios básicos de clasificación de los modelos ANOVA. Debe enfatizarse que estos son principios justos. Un estudio detallado de las características de cada modelo requiere un estudio más profundo por separado. Tareas de prueba para la conferencia ¿Sobre qué características estadísticas se tratan las hipótesis en el análisis de varianza? Relativo a dos variaciones Relativo a un promedio Relativo a algunos promedios Relativo a una varianza ¿Cuál es el contenido de la hipótesis alternativa en el análisis de varianza? Las variaciones comparadas no son iguales entre sí Todos los promedios comparados no son iguales. Al menos dos promedios generales no son iguales La varianza intergrupal es mayor que la varianza intragrupal ¿Cuáles son los niveles de significación más utilizados en el análisis de varianza? Si la variación dentro del grupo es mayor que la variación entre los grupos, ¿debería el ANOVA continuar o coincidir inmediatamente con H0 o con AN? 1. ¿Debería continuar con las variaciones requeridas? 2. Uno debería estar de acuerdo con H0 3. De acuerdo con ON Si se encontró que la varianza dentro del grupo es igual a la varianza entre grupos, ¿qué debe seguir el análisis de varianza? De acuerdo con la hipótesis nula de igualdad de medias generales De acuerdo con la hipótesis alternativa sobre la presencia de al menos un par de medios desiguales entre sí ¿Qué varianza debería estar siempre en el numerador al calcular la prueba de F-Fisher? Solo dentro del grupo De todos modos, intergrupo Intergrupo, si es más intragrupo ¿Cuál debería ser el valor real del criterio F-Fisher? Siempre menos de 1 Siempre mayor que 1 Igual o mayor que 1 ¿De qué depende el valor tabular del criterio F-Fisher? 1.Desde el nivel de significancia aceptado 2. Del número de grados de libertad de la variación total 3. Del número de grados de libertad de variación intergrupal 4. Sobre el número de grados de libertad de variación intragrupo 5. ¿A partir del valor del valor real del criterio F-Fisher? Un aumento en el número de observaciones en cada grupo con variaciones iguales aumenta la probabilidad de aceptar …… 1 hipótesis nula 2 hipótesis alternativa 3. No afecta la aceptación de hipótesis nulas y alternativas ¿Cuál es el punto de especificar los resultados del análisis de varianza? Aclarar si los cálculos de desviaciones se han realizado correctamente Establecer cuáles de los promedios generales resultaron ser iguales entre sí. Aclarar cuáles de los promedios generales no son iguales entre sí. ¿Es cierta la afirmación: "Al especificar los resultados del análisis de varianza, todos los promedios generales resultaron ser iguales entre sí" Puede estar bien y mal No es cierto, esto puede deberse a errores en los cálculos. ¿Es posible, al especificar el análisis de varianza, llegar a la conclusión de que todos los promedios generales no son iguales entre sí? 1. Es posible 2. Posiblemente en casos excepcionales 3. Es imposible en principio. 4. Solo es posible si comete errores en los cálculos. Si la hipótesis nula fue aceptada por el criterio F-Fisher, ¿es necesario especificar el análisis de varianza? 1.Requiere 2.No es necesario 3.A discreción del analista de ANOVA ¿En qué caso se utiliza la prueba de Tukey para concretar los resultados del análisis de varianza? 1. Si el número de observaciones por grupos (muestras) es el mismo 2. Si el número de observaciones por grupos (muestras) es diferente 3.Si hay muestras con números iguales y desiguales pereza ¿Qué es NDS al especificar los resultados del análisis de varianza basado en la prueba de Tukey? 1.Produzca el error promedio por el valor real del criterio 2. El producto del error promedio por el valor de la tabla del criterio. 3. La razón de cada diferencia entre las medias muestrales y error promedio 4. Diferencia entre medias muestrales Si la muestra se divide en grupos de acuerdo con 2 características, ¿cuántas fuentes deben dividirse al menos en la variación total de la característica? Si las observaciones por muestras (grupos) son dependientes, ¿en cuántas fuentes debería dividirse la variación total (atributo de agrupación uno)? ¿Cuál es la fuente (causa) de la variación intergrupal? Juego de azar Acción combinada del juego de azar y factor Acción de los factores Averigüe después del análisis de varianza ¿Cuál es la fuente (causa) de la variación intragrupo? 1 juego de azar 2.Acción combinada del juego de azar y factor. 3. La acción de los factores 4. Se averiguará después del análisis de varianza. ¿Qué método de transformar los datos de origen se utiliza si los valores característicos se expresan en fracciones? Logaritmo Extrayendo la raíz Transformación phi Clase 8 Correlación anotación El método más importante para estudiar la relación entre signos es el método de correlación. Esta conferencia revela el contenido de este método, aproximaciones a la expresión analítica de esta conexión. Se presta especial atención a indicadores tan específicos como los indicadores de la rigidez de la comunicación. Palabras clave Correlación. Método de mínimos cuadrados. Coeficiente de regresion. Coeficientes de determinación y correlación. Problemas resueltos Relación funcional y de correlación Etapas de la construcción de la ecuación de correlación de la comunicación. Interpretación de los coeficientes de la ecuación Indicadores de estanqueidad Evaluación de indicadores de comunicación seleccionados Unidad modular 1 La esencia de la correlación. Etapas de construcción de la ecuación de correlación de la comunicación, interpretación de los coeficientes de la ecuación. El propósito y los objetivos de estudiar una unidad modular 1 consisten en comprender las características de la correlación. Dominar el algoritmo para la construcción de la ecuación de comunicación, comprender el contenido de los coeficientes de la ecuación. La esencia de la correlación En los fenómenos naturales y sociales, hay dos tipos de conexiones: una conexión funcional y una conexión de correlación. En una conexión funcional, cada valor del argumento corresponde a valores estrictamente definidos (uno o más) de la función. Un ejemplo de relación funcional es la relación entre la circunferencia y el radio, que se expresa mediante la ecuación 1.2

Etapas de la construcción de la ecuación de correlación de la comunicación.. Como una relación funcional, una correlación se expresa mediante una ecuación de relación. Para construirlo, debe seguir constantemente los siguientes pasos (etapas). Primero, se deben comprender las relaciones de causa y efecto, averiguar la subordinación de los signos, es decir, cuáles de ellos son las razones (signos factoriales) y cuáles son la consecuencia (signos efectivos). Las relaciones causales entre características las establece la teoría del sujeto donde se utiliza el método de correlación. Por ejemplo, la ciencia de la "anatomía humana" le permite decir cuál es la fuente de la relación entre el peso y la altura, cuál de estos signos es un factor, cuyo resultado, la ciencia de la "economía" revela la lógica de la relación entre precio y oferta, establece qué y en qué etapa está la causa y cuál es el efecto ... Sin una justificación teórica tan preliminar, la interpretación de los resultados obtenidos en el futuro es difícil y, en ocasiones, puede llevar a conclusiones absurdas. Una vez establecida la presencia de relaciones de causa y efecto, estas relaciones deben formalizarse, es decir, expresarse mediante una ecuación de comunicación, eligiendo primero el tipo de ecuación. Se pueden recomendar varias técnicas para elegir el tipo de ecuación. Puede recurrir a la teoría del tema donde se utiliza el método de correlación, por ejemplo, la ciencia de la "agroquímica" puede haber recibido ya una respuesta a la pregunta de qué ecuación debe expresar la relación: rendimiento - fertilizantes. Si no hay tal respuesta, entonces para seleccionar una ecuación, debe usar algunos datos empíricos, procesándolos apropiadamente. Debe decirse de inmediato que una vez elegido el tipo de ecuación basado en datos empíricos, se debe entender claramente que este tipo de ecuación se puede utilizar para describir la relación de los datos utilizados. La técnica principal para procesar estos datos es la construcción de gráficos, cuando los valores del atributo del factor se trazan en el eje de abscisas y los posibles valores del atributo efectivo se trazan en el eje de ordenadas. Dado que, por definición, el mismo valor del atributo factor corresponde a un conjunto de valores indefinidos del atributo efectivo, como resultado de las acciones anteriores, recibiremos un cierto conjunto de puntos, que se denomina campo de correlación. La vista general del campo de correlación permite en varios casos hacer una suposición sobre la forma posible de la ecuación. Con el desarrollo moderno de la tecnología informática, uno de los principales métodos para elegir una ecuación es enumerar varios tipos de ecuaciones. , mientras que la mejor ecuación es la que proporciona el mayor coeficiente de determinación, el habla que se comentará a continuación. Antes de proceder con los cálculos, es necesario verificar en qué medida los datos empíricos utilizados para construir la ecuación satisfacen ciertos requisitos. Los requisitos se relacionan con las características factoriales y con el conjunto de datos. Los signos de los factores, si hay varios, deben ser independientes entre sí. En cuanto a la totalidad, debe ser, en primer lugar, homogénea (el concepto de homogeneidad se consideró antes) y, en segundo lugar, bastante amplio. Cada rasgo factorial debe dar cuenta de al menos 8-10 observaciones. Después de elegir una ecuación, el siguiente paso es calcular los coeficientes de la ecuación. Los coeficientes de ecuación se calculan con mayor frecuencia utilizando el método de mínimos cuadrados. Desde el punto de vista de la correlación, el uso del método de mínimos cuadrados consiste en obtener tales coeficientes de la ecuación de manera que Resolviendo este sistema con respecto a a y B

,

obtenemos los valores necesarios de los coeficientes. La exactitud del cálculo de los coeficientes se verifica mediante la igualdad ¿Para qué se utiliza el análisis de varianza?

El propósito del análisis de varianza es estudiar la presencia o ausencia de un efecto significativo de cualquier factor cualitativo o cuantitativo sobre los cambios en el rasgo efectivo investigado. Para ello, un factor, que presumiblemente tiene o no una influencia significativa, se divide en clases de gradación (es decir, grupos) y se determina si la influencia del factor es la misma mediante el estudio de la significancia entre las medias en los conjuntos de datos correspondientes. a las gradaciones de factores. Ejemplos: se investiga la dependencia de la ganancia de la empresa del tipo de materias primas utilizadas (entonces las clases de clasificación son los tipos de materias primas), la dependencia del costo de producción de una unidad de producción del tamaño de la división de la empresa (luego las clases de gradación son las características del tamaño de la división: grande, mediano, pequeño). El número mínimo de clases de calificación (grupos) es dos. Las clases de graduación pueden ser cualitativas o cuantitativas. ¿Por qué el análisis de varianza se llama análisis de varianza?

El análisis de varianza examina la razón de dos varianzas. La varianza, como sabemos, es una característica de la dispersión de datos alrededor de la media. La primera es la varianza explicada por la influencia del factor, que caracteriza la dispersión de valores entre las gradaciones del factor (grupos) alrededor de la media de todos los datos. La segunda es la varianza inexplicable, que caracteriza la dispersión de datos dentro de gradaciones (grupos) alrededor de las medias de los propios grupos. La primera variación se puede llamar intergrupo y la segunda, intragrupo. La razón de estas varianzas se denomina razón de Fisher real y se compara con el valor crítico de la razón de Fisher. Si la proporción de Fisher real es mayor que la crítica, entonces las calificaciones promedio de gradación difieren entre sí y el factor en estudio afecta significativamente el cambio en los datos. Si es menor, entonces las calificaciones promedio de gradación no difieren entre sí y el factor no tiene un impacto significativo. ¿Cómo se formulan, aceptan y rechazan las hipótesis en ANOVA?

En el análisis de varianza se determina el peso específico del impacto total de uno o más factores. La importancia de la influencia del factor se determina probando las hipótesis: Si la influencia de un factor no es significativa, entonces la diferencia entre las clases de gradación de este factor también es insignificante y en el curso del análisis de varianza la hipótesis nula H0

no se rechaza. Si la influencia del factor es significativa, entonces la hipótesis nula H0

rechazado: no todas las clases de gradación tienen la misma media, es decir, entre las posibles diferencias entre las clases de gradación, una o más son significativas. Algunos conceptos más de análisis de varianza.

Un complejo estadístico en ANOVA es una tabla de datos empíricos. Si todas las clases de gradaciones tienen el mismo número de opciones, entonces el complejo estadístico se llama homogéneo (homogéneo), si el número de opciones es diferente, heterogéneo (heterogéneo). Dependiendo del número de factores evaluados, se distingue el análisis de varianza unidireccional, bidireccional y multivariado.

basado en el hecho de que la suma de los cuadrados de las desviaciones del complejo estadístico se puede dividir en componentes: SS = SS a + SS mi, SS

SSa a suma de cuadrados de desviaciones, SSmi- Suma inexplicable de cuadrados de desviaciones o suma de cuadrados de desviaciones del error. Si a traves de norteI designar el número de opciones en cada grado de gradación (grupo) y a es el número total de gradaciones del factor (grupos), luego es el número total de observaciones y se pueden obtener las siguientes fórmulas: número total de cuadrados de desviaciones: atribuido al factor a suma de cuadrados de desviaciones: Suma inexplicable de cuadrados de desviaciones o suma de cuadrados de desviaciones de error: (grupo). Además, donde es la varianza de la gradación del factor (grupo). Para realizar un análisis de varianza unidireccional para los datos de un complejo estadístico, debe encontrar la razón de Fisher real: la razón de la varianza explicada por la influencia del factor (intergrupo) y la varianza inexplicada (intragrupo). : y compárelo con el valor crítico de Fisher. Las variaciones se calculan de la siguiente manera: Varianza explicada, Varianza inexplicable va = a − 1

- el número de grados de libertad de la varianza explicada, ve = norte − a

- el número de grados de libertad de varianza inexplicable, v = norte El valor crítico de la razón de Fisher con ciertos valores del nivel de significancia y grados de libertad se puede encontrar en tablas estadísticas o calcularse usando la función de MS Excel F.OBR (la figura siguiente, para aumentarla, haga clic en ella con el boton izquierdo del raton). La función requiere que se ingresen los siguientes datos: Probabilidad - nivel de significancia α

, Degrees_freedom1 es el número de grados de libertad de la varianza explicada va, Degrees_freedom2 es el número de grados de libertad de varianza inexplicable vmi. Si el valor real de la razón de Fisher es mayor que el crítico (), entonces la hipótesis nula se rechaza con un nivel de significancia α

... Esto significa que el factor afecta significativamente el cambio en los datos y los datos dependen del factor con una probabilidad PAG = 1 − α

. Si el valor real de la razón de Fisher es menor que el crítico (), entonces la hipótesis nula no puede rechazarse con un nivel de significancia α

... Esto significa que el factor no afecta significativamente los datos con una probabilidad PAG = 1 − α

. Ejemplo 1. Es necesario averiguar si el tipo de materias primas utilizadas afecta el beneficio de la empresa. En seis clases de gradación (grupos) del factor (primer tipo, segundo tipo, etc.), se recopilan datos sobre el beneficio de la producción de 1000 unidades de productos en millones de rublos durante 4 años. a= 6 y en cada clase (grupo) nortei = 4 observación. Número total de observaciones norte = 24

. Número de grados de libertad: va = a − 1 = 6 − 1 = 5

, ve = norte − a = 24 − 6 = 18

, v = norte − 1 = 24 − 1 = 23

. Calculemos las varianzas: Dado que la actitud real de Fischer es más crítica: con un nivel de significancia α

= 0.05, concluimos que la ganancia de la empresa, dependiendo del tipo de materias primas utilizadas en la producción, difiere significativamente. O, lo que es lo mismo, rechazamos la hipótesis principal sobre la igualdad de medias en todas las clases de gradación factorial (grupos). En el ejemplo que se acaba de considerar, cada clase de calificación factorial tenía el mismo número de opciones. Pero, como se mencionó en la introducción, la cantidad de opciones puede ser diferente. Y esto de ninguna manera complica el procedimiento ANOVA. Este es el siguiente ejemplo. Ejemplo 2. Es necesario averiguar si el costo de producción de una unidad de producción depende del tamaño de la división de la empresa. El factor (tamaño de la unidad) se divide en tres grados (grupos): pequeño, mediano, grande. Datos generalizados correspondientes a estos grupos sobre el coste de producción de una unidad del mismo tipo de producto durante un período determinado. El número de clases de gradación de factores (grupos) a= 3, número de observaciones en clases (grupos) norte1

= 4

,

norte2

= 7

,

norte3

= 6

... Número total de observaciones norte = 17

. Número de grados de libertad: va = a − 1 = 2

, ve = norte − a = 17 − 3 = 14

, v = norte − 1 = 16

. Calculemos la suma de los cuadrados de las desviaciones: Calculemos las varianzas: Calculemos la razón de Fisher real: Razón crítica de Fischer: Dado que el valor real de la razón de Fisher es menor que el crítico:, llegamos a la conclusión de que el tamaño de la unidad empresarial no afecta significativamente el costo de producción. O, lo que es lo mismo, con una probabilidad del 95%, aceptamos la hipótesis principal de que el costo promedio de producción de una unidad de un mismo producto en las divisiones pequeñas, medianas y grandes de una empresa no difiere significativamente. El análisis de varianza unidireccional se puede realizar utilizando el procedimiento de MS Excel ANOVA unidireccional... Lo usamos para analizar datos sobre la relación entre el tipo de materias primas utilizadas y el beneficio de la empresa del ejemplo 1. Servicio / Análisis de datos y elige una herramienta de análisis ANOVA unidireccional. En la ventana Intervalo de entrada indicamos el área de datos (en nuestro caso es $ A $ 2: $ E $ 7). Indicamos cómo se agrupa el factor, por columnas o por filas (en nuestro caso, por filas). Si la primera columna contiene los nombres de las clases de factores, marque la casilla Etiquetas de la primera columna... En la ventana Alfa indicar el nivel de significancia α

= 0,05

. La segunda tabla, Análisis de varianza, contiene datos sobre los valores del factor entre grupos y dentro de los grupos y los totales. Estos son la suma de las desviaciones al cuadrado (SS), el número de grados de libertad (gl), la varianza (MS). Las últimas tres columnas contienen el valor real del índice de Fisher (F), el nivel p (valor P) y el valor crítico del índice de Fisher (F crítico). Dado que el valor real de la razón de Fischer (6,89) es mayor que el valor crítico (2,77), con una probabilidad del 95% rechazamos la hipótesis nula sobre la igualdad de la productividad media al utilizar todo tipo de materias primas, es decir, Concluimos que el tipo de materias primas utilizadas afecta a las empresas lucrativas. El análisis de varianza bidireccional se utiliza para verificar la posible dependencia de un rasgo efectivo en dos factores: A y B... Luego a- el número de gradaciones del factor A y B- el número de gradaciones del factor B... En el complejo estadístico, la suma de los cuadrados de los residuos se divide en tres componentes: SS = SS a + SS b + SS mi, Promedio de observaciones en cada gradación del factor A

, B

. A

, Dispersión explicada por la influencia del factor B

, va = a − 1

A

, vb = B − 1

- el número de grados de libertad de la dispersión, explicado por la influencia del factor B

, ve = ( a − 1)(B − 1)

v = ab- 1 - el número total de grados de libertad. Si los factores son independientes entre sí, se proponen dos hipótesis nulas y las hipótesis alternativas correspondientes para determinar la importancia de los factores: por factor A

: H0

: μ

1A = μ

2A = ... = μ

Automóvil club británico, H1

: No todo μ

I a son iguales; por factor B

: H0

: μ

1B = μ

2B = ... = μ

aB, H1

: No todo μ

iB son iguales. A Para determinar la influencia de un factor B, hay que comparar la actitud actual de Fischer con la actitud crítica de Fischer. α

PAG = 1 − α

. α

PAG = 1 − α

. Ejemplo 3. Se proporciona información sobre el consumo medio de combustible por cada 100 kilómetros en litros, según el volumen del motor y el tipo de combustible. Es necesario comprobar si el consumo de combustible depende del tamaño del motor y del tipo de combustible. Solución. Por factor A número de clases de calificación a= 3, para el factor B número de clases de calificación B = 3

. Calculamos la suma de los cuadrados de las desviaciones: Variaciones correspondientes: A

Razón real de Fischer para un factor B

El análisis de varianza bidireccional sin repeticiones se puede realizar utilizando el procedimiento de MS Excel. Lo usamos para analizar datos sobre la relación entre el tipo de combustible y su consumo del ejemplo 3. En el menú de MS Excel, ejecute el comando Servicio / Análisis de datos y elige una herramienta de análisis Análisis de varianza bidireccional sin repeticiones. Completamos los datos de la misma manera que en el caso del análisis de varianza unidireccional. Como resultado del procedimiento, se muestran dos tablas. La primera tabla es Totales. Contiene datos sobre todas las clases de gradación de factores: número de observaciones, valor total, valor medio y varianza. La segunda tabla, Análisis de varianza, contiene datos sobre las fuentes de variación: dispersión entre filas, dispersión entre columnas, dispersión de errores, dispersión total, suma de desviaciones cuadradas (SS), número de grados de libertad (gl), varianza (MS ). Las últimas tres columnas contienen la relación de Fischer real (F), el nivel p (valor P) y la relación de Fischer crítica (Fcrit). Factor A(cilindrada del motor) se agrupa en líneas. Dado que la relación de Fischer real de 5.28 es menor que el crítico 6.94, asumimos con un 95% de probabilidad que el consumo de combustible no depende del tamaño del motor. Factor B(tipo de combustible) se agrupa en columnas. La relación de Fischer real de 13.56 es mayor que la crítica de 6.94, por lo tanto, con una probabilidad del 95%, asumimos que el consumo de combustible depende de su tipo. El análisis de varianza bidireccional con repeticiones se utiliza para verificar no solo la posible dependencia del rasgo efectivo en dos factores: A y B, sino también la posible interacción de factores A y B... Luego a- el número de gradaciones del factor A y B- el número de gradaciones del factor B, r- el número de repeticiones. En el complejo estadístico, la suma de los cuadrados de los residuos se divide en cuatro componentes: SS = SS a + SS b + SS ab + SS mi, Número promedio de observaciones en cada combinación de gradaciones de factores A y B

, norte = abr- el número total de observaciones. Las variaciones se calculan de la siguiente manera: Dispersión explicada por la influencia del factor A

, Dispersión explicada por la influencia del factor B

, va = a − 1

- el número de grados de libertad de la dispersión, explicado por la influencia del factor A

, vb = B − 1

- el número de grados de libertad de la dispersión, explicado por la influencia del factor B

, vab = ( a − 1)(B − 1)

- el número de grados de libertad de la varianza explicada por la interacción de factores A y B

, ve = ab(r − 1)

- el número de grados de libertad de la varianza inexplicable o varianza del error, v = abr- 1 - el número total de grados de libertad. Si los factores son independientes entre sí, se proponen tres hipótesis nulas y las hipótesis alternativas correspondientes para determinar la importancia de los factores: por factor A

: H0

: μ

1A = μ

2A = ... = μ

Automóvil club británico, H1

: No todo μ

I a son iguales; por factor B

:

Determinar la influencia de la interacción de factores. A y B, hay que comparar la actitud actual de Fischer con la actitud crítica de Fischer. Si la razón de Fisher real es mayor que la razón de Fisher crítica, entonces la hipótesis nula debe rechazarse con un nivel de significancia. α

... Esto significa que el factor afecta significativamente los datos: los datos dependen del factor con una probabilidad PAG = 1 − α

. Si la razón de Fischer real es menor que la razón de Fisher crítica, entonces la hipótesis nula debe aceptarse con un nivel de significancia. α

... Esto significa que el factor no afecta significativamente los datos con una probabilidad PAG = 1 − α

. sobre la interacción de factores A y B: La actitud real de Fischer es menos que crítica, por lo tanto, la interacción entre la campaña publicitaria y una tienda en particular no es esencial. El análisis de varianza bidireccional con repeticiones se puede realizar utilizando el procedimiento de MS Excel. Lo usamos para analizar datos sobre la relación entre los ingresos de la tienda y la elección de una tienda en particular y la campaña publicitaria del Ejemplo 4. En el menú de MS Excel, ejecute el comando Servicio / Análisis de datos y elige una herramienta de análisis Análisis de varianza bidireccional con repeticiones. Completamos los datos de la misma manera que en el caso del análisis de varianza bidireccional sin repeticiones, con el agregado de que el número de repeticiones debe ingresarse en el número de filas para la ventana de selección. Como resultado del procedimiento, se muestran dos tablas. La primera tabla consta de tres partes: las dos primeras corresponden a cada una de las dos campañas publicitarias, la tercera contiene datos de ambas campañas publicitarias. Las columnas de la tabla contienen información sobre todas las clases de gradación del segundo factor: la tienda: el número de observaciones, el valor total, el valor medio y la varianza. La segunda tabla contiene datos sobre la suma de las desviaciones al cuadrado (SS), el número de grados de libertad (gl), la varianza (MS), el valor real de la razón de Fisher (F), el nivel p (valor P) y el valor crítico de la razón de Fisher (Fcrit) para diferentes fuentes de variación: dos factores que se dan en filas (muestra) y columnas, interacción de factores, errores (dentro) e indicadores totales (total). Por factor B El índice real de Fischer es mayor que el crítico, por lo tanto, con una probabilidad del 95%, los ingresos difieren significativamente entre las tiendas. Para la interacción de factores A y B La actitud real de Fischer es menos que crítica, por lo tanto, con un 95% de probabilidad, la interacción entre la campaña publicitaria y una tienda en particular no es significativa. Todos los temas relacionados "Estadística matemática" ANOVA(del latín Dispersio - dispersión / en inglés Análisis de varianza - ANOVA) se utiliza para estudiar la influencia de una o más variables cualitativas (factores) sobre una variable cuantitativa dependiente (respuesta). El análisis de varianza se basa en el supuesto de que algunas variables pueden ser consideradas como causas (factores, variables independientes), y otras como consecuencias (variables dependientes). Las variables independientes a veces se denominan factores ajustables precisamente porque en el experimento el investigador tiene la capacidad de variarlas y analizar el resultado resultante. El objetivo principal Análisis de variación(ANOVA) es un estudio de la importancia de las diferencias entre medias mediante la comparación (análisis) de las varianzas. Al dividir la varianza total en múltiples fuentes, es posible comparar la varianza causada por la diferencia entre grupos con la varianza causada por la variabilidad dentro del grupo. Si la hipótesis nula es verdadera (sobre la igualdad de medias en varios grupos de observaciones seleccionados de la población general), la estimación de la varianza asociada con la variabilidad dentro del grupo debe estar cerca de la estimación de la varianza entre los grupos. Si simplemente está comparando las medias en dos muestras, el análisis de varianza dará el mismo resultado que la prueba t habitual para muestras independientes (si se comparan dos grupos independientes de objetos u observaciones) o la prueba t para muestras dependientes (si dos las variables se comparan en el mismo y el mismo conjunto de objetos u observaciones). La esencia del análisis de varianza es dividir la varianza total del rasgo en estudio en componentes individuales, debido a la influencia de factores específicos, y probar hipótesis sobre la importancia de la influencia de estos factores en el rasgo en estudio. Al comparar los componentes de la varianza entre sí utilizando la prueba F de Fisher, es posible determinar qué proporción de la variabilidad general del rasgo efectivo se debe a la acción de los factores regulados. El material de partida para el análisis de varianza son los datos del estudio de tres o más muestras: que pueden ser iguales o desiguales en número, tanto conectadas como incoherentes. Por el número de factores controlados detectados, el análisis de varianza puede ser univariado(en este caso, se estudia la influencia de un factor en los resultados del experimento), dos factores(al estudiar la influencia de dos factores) y multifactorial(permite evaluar no solo la influencia de cada uno de los factores por separado, sino también su interacción). El ANOVA pertenece al grupo de los métodos paramétricos y, por lo tanto, solo debe utilizarse cuando se haya comprobado que la distribución es normal. El ANOVA se utiliza cuando la variable dependiente se mide en términos de razones, intervalos u orden, y las variables que influyen son de naturaleza no numérica (escala de denominación). En problemas que se resuelven mediante análisis de varianza, existe una respuesta de carácter numérico, que se ve afectada por varias variables de carácter nominal. Por ejemplo, varios tipos de dietas para la alimentación del ganado o dos formas de mantenerlas, etc. Ejemplo 1: Varios quioscos de farmacia operaban en tres ubicaciones diferentes durante la semana. En el futuro, solo podemos dejar uno. Es necesario determinar si existe una diferencia estadísticamente significativa entre los volúmenes de venta de medicamentos en los quioscos. Si es así, elegiremos el kiosco con mayor volumen promedio de ventas diarias. Si la diferencia en el volumen de ventas resulta ser estadísticamente insignificante, entonces otros indicadores deberían ser la base para elegir un quiosco. Ejemplo 2: Comparación de los contrastes de medias grupales. Siete sesgos políticos están ordenados de extremadamente liberales a extremadamente conservadores, y el contraste lineal se usa para probar si existe una tendencia distinta de cero hacia valores medios crecientes entre los grupos, es decir, si hay un aumento lineal significativo en la edad promedio cuando se consideran grupos. ordenado en la dirección de liberal a conservador. Ejemplo 3: Análisis de varianza bidireccional. El número de ventas de productos, además del tamaño de la tienda, suele estar influenciado por la ubicación de los estantes con el producto. Este ejemplo contiene cifras de ventas semanales para cuatro diseños de estantes y tres tamaños de tienda. Los resultados del análisis muestran que ambos factores, la ubicación de los estantes con el producto y el tamaño de la tienda, afectan el número de ventas, pero su interacción no es significativa. Ejemplo 4: ANOVA unidimensional: diseño de bloque completo aleatorizado con dos tratamientos. Se investiga el efecto de todas las combinaciones posibles de tres grasas y tres desgarradores en el pan. Cuatro muestras de harina de cuatro fuentes diferentes sirvieron como factores de bloqueo, por lo que es necesario determinar la importancia de la interacción de aflojamiento de grasa. Después de eso, determine las diversas posibilidades de elegir contrastes, que permitan descubrir qué combinaciones de niveles de factores difieren. Ejemplo 5: Modelo de plano jerárquico (anidado) con efectos mixtos. Se estudia el efecto de cuatro cabezales seleccionados aleatoriamente instalados en una máquina sobre la deformación de los soportes de cátodos de vidrio producidos. (Los cabezales están integrados en la máquina, por lo que no se puede usar el mismo cabezal en diferentes máquinas). El efecto de cabeza se trata como un factor aleatorio. Las estadísticas de ANOVA muestran que no hay diferencias significativas entre máquinas, pero hay indicios de que los cabezales pueden diferir. La diferencia entre todas las máquinas no es significativa, pero para dos de ellas la diferencia entre los tipos de cabezales es significativa. Ejemplo 6: Análisis unidimensional de mediciones repetidas utilizando un plan de parcelas divididas. Este experimento se realizó para determinar el efecto de la calificación de ansiedad de un individuo sobre la aprobación del examen en cuatro intentos consecutivos. Los datos están organizados de modo que se puedan ver como un grupo de subconjuntos de todo el conjunto de datos ("parcela completa"). El efecto de la ansiedad fue insignificante, mientras que el efecto de intentarlo fue significativo. Los datos constan de varias series de observaciones (procesamiento), que se consideran realizaciones de muestras independientes. La hipótesis inicial dice que no hay diferencia en los tratamientos, es decir se supone que todas las observaciones pueden considerarse como una muestra de la población general: Los datos son observaciones duplicadas: De donde viene el nombre Análisis de variación? Puede parecer extraño que el procedimiento para comparar medias se llame análisis de varianza. De hecho, esto se debe al hecho de que al examinar la significancia estadística de la diferencia entre las medias de dos (o más) grupos, en realidad estamos comparando (analizando) las varianzas muestrales. Se propone el concepto fundamental de análisis de varianza Pescador en 1920. Quizás el término más natural sería análisis de suma de cuadrados o análisis de variación, pero tradicionalmente se usa el término ANOVA. Inicialmente, ANOVA se desarrolló para procesar datos obtenidos de experimentos especialmente diseñados y se consideró el único método que investiga correctamente las relaciones causales. El método se utilizó para evaluar experimentos en la producción de cultivos. Posteriormente, el significado científico general del análisis de varianza para experimentos en psicología, pedagogía, medicina, etc. |

||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| Leer: |

|---|

Popular:

Nuevo

- Distribución de probabilidad normal de una variable aleatoria continua

- Interpolación de splines Interpolación cúbica en línea

- Fracciones y decimales y acciones sobre ellos

- Ecuación general de investigación directa

- Daniel Jacobs: breve biografía y carrera de un boxeador estadounidense

- El golpe más fuerte de un boxeador

- A alexander ustinov le gusta leer antes de la pelea Cambio de promotor, nuevas victorias

- Biografía ¿Cuándo fue la última pelea de Meni Pacquiao?

- Biografía de Manny Pacquiao Pacquiao fight statistics

- Cómo los atletas millonarios van a la bancarrota La condición de Tyson hoy

... El promedio de altura en este ejemplo es de 173 centímetros. Basado en esto,

... El promedio de altura en este ejemplo es de 173 centímetros. Basado en esto,

... Si no está resaltado, entonces esta variación puede aumentar significativamente la variación intragrupo (

... Si no está resaltado, entonces esta variación puede aumentar significativamente la variación intragrupo (  ), que puede distorsionar los resultados del análisis de varianza.

), que puede distorsionar los resultados del análisis de varianza. )

?

)

? ... A cada valor del radio r corresponde a un solo valor para la circunferencia L

.

En caso de correlación, cada valor del atributo factor corresponde a varios valores no del todo definidos del atributo efectivo. Ejemplos de correlaciones son la relación entre el peso de una persona (rasgo efectivo) y su altura (rasgo factor), la relación entre la cantidad de fertilizante aplicado y el rendimiento, entre el precio y la cantidad del producto ofertado. La fuente del surgimiento de una correlación es el hecho de que, por regla general, en la vida real, el valor de un atributo efectivo depende de muchos factores, incluidos aquellos que tienen una naturaleza aleatoria de su cambio. Por ejemplo, el mismo peso de una persona depende de la edad, el sexo, la dieta, la ocupación y muchos otros factores. Pero al mismo tiempo, es obvio que el crecimiento es el factor decisivo en general. En vista de estas circunstancias, la correlación debe definirse como una relación incompleta, que se puede establecer y estimar solo si hay un gran número de observaciones, en promedio.

... A cada valor del radio r corresponde a un solo valor para la circunferencia L

.

En caso de correlación, cada valor del atributo factor corresponde a varios valores no del todo definidos del atributo efectivo. Ejemplos de correlaciones son la relación entre el peso de una persona (rasgo efectivo) y su altura (rasgo factor), la relación entre la cantidad de fertilizante aplicado y el rendimiento, entre el precio y la cantidad del producto ofertado. La fuente del surgimiento de una correlación es el hecho de que, por regla general, en la vida real, el valor de un atributo efectivo depende de muchos factores, incluidos aquellos que tienen una naturaleza aleatoria de su cambio. Por ejemplo, el mismo peso de una persona depende de la edad, el sexo, la dieta, la ocupación y muchos otros factores. Pero al mismo tiempo, es obvio que el crecimiento es el factor decisivo en general. En vista de estas circunstancias, la correlación debe definirse como una relación incompleta, que se puede establecer y estimar solo si hay un gran número de observaciones, en promedio. = min, es decir, que la suma de los cuadrados de las desviaciones de los valores reales del indicador efectivo (

= min, es decir, que la suma de los cuadrados de las desviaciones de los valores reales del indicador efectivo (  ) de los calculados según la ecuación (

) de los calculados según la ecuación (  ) fue el valor mínimo. Este requisito se cumple construyendo y resolviendo un sistema bien conocido de las llamadas ecuaciones normales. Si como la ecuación de la correlación entre y y X se elige la ecuación de la línea recta

) fue el valor mínimo. Este requisito se cumple construyendo y resolviendo un sistema bien conocido de las llamadas ecuaciones normales. Si como la ecuación de la correlación entre y y X se elige la ecuación de la línea recta  , donde el sistema de ecuaciones normales, como saben, será el siguiente:

, donde el sistema de ecuaciones normales, como saben, será el siguiente: